博客

什么是多层感知以及何时使用 MLP 与 Transformers

Transformer 模型最近占据了人工智能的头条新闻,它们的能力确实令人印象深刻。尽管生成式人工智能和 LLM 正在被注入每个行业,但重要的是要意识到它们并不是每个人工智能挑战的通用解决方案。一个更简单的多层感知器神经网络(MLP)可以证明在特定用例中更有效。

传统的 MLP 是许多现代深度学习系统的基础。他们经过验证的设计可以在更简单的日常数据问题上胜过更复杂的模型,需要更少的计算资源。我们将探索 MLP 比 Transformers 更优越的选择场景——简单性是一个优势。

多层感知器(MLP)是神经网络的基础架构之一,也是大多数神经网络(包括Transformers)的关键构建块。这是一种前馈神经网络,由按顺序排列的多层节点组成:输入层、一个或多个隐藏层和输出层。一层中的每个节点(或神经元)都连接到下一层的每个节点,这就是为什么 MLP 通常被称为全连接网络。

MLP 与基本单层感知器的区别在于,它们能够通过堆叠多个隐藏层并应用非线性激活函数(如 ReLU(校正线性单元)、sigmoid 或 tanh)来处理非线性关系。这些函数允许网络学习复杂的模式,而不仅仅是简单的线性可分离性。

-

MLP 的主要特征:

-

前馈架构:数据在一个方向上流动——从输入到输出——没有循环或循环。

-

全连接层:一层中的每个神经元都连接到下一层的每个神经元。

-

反向传播学习:通过使用误差反向传播的优化算法(通常是随机梯度下降)来更新权重。

-

激活函数:在层之间插入非线性函数,使网络能够近似非线性映射。

尽管 MLP 很简单,但它们是强大的通用函数逼近器。给定足够的深度和宽度,它们理论上可以模拟任何连续函数。然而,这种表达能力需要权衡,特别是在效率和电感偏置方面。MLP 缺乏 CNN 或 Transformer 等架构中的结构优势,这些架构是专门为利用图像或序列数据中的模式而设计的。

在实践中,MLP 在结构化的表格数据集上表现最佳,其中每个输入特征都是独立的,不存在空间或顺序关系。在这些领域中,MLP的简单结构通常不仅足够,而且由于其效率和易于解释而更优越。

虽然与当今的高级架构相比,MLP 可能看起来很基础,但它们在现实世界的应用中仍然被广泛使用,在这些应用中,它们的优势与手头的任务相一致。

Transformers 是一种较新和先进的神经网络架构,最著名的是为 LLM 和 Generative AI 提供动力。与 MLP 等传统前馈网络不同,Transformers 是专门为序列中元素之间的关系建模而设计的,有利于自然语言处理、计算机视觉和时间序列预测。

Transformer 的核心是注意力机制,它允许模型权衡不同输入元素相对于彼此的重要性。Transformers 不是按顺序处理数据(如 MLP),而是将输入作为一个整体进行分析。这种全局上下文意识是他们在翻译、总结和问答等 LLM 任务中表现的关键。

Transformers 在非结构化数据领域表现出色,例如:

-

文本:语言建模、分类、摘要和机器翻译

-

视觉:通过视觉 Transformer (ViTs)进行图像分类、目标检测和分割

-

多模式任务:在单个模型中组合文本、图像和音频输入

然而,这种灵活性是有代价的。Transformers 需要大量的计算资源、大量的训练数据和仔细的超参数调整。对于小型或结构化的数据集,它们的复杂性可能是不必要的,甚至可能适得其反。

总之,Transformers 功能强大,用途广泛,尤其适用于涉及复杂背景或关系的任务。但对于数据结构化且相对简单的现实世界问题,它们的开销和容易产生幻觉可能会超过它们的好处。MLP 可能是更明智的选择,因为它们重量轻、可靠性高。

虽然 Transformer 在自然语言和视觉任务方面的能力占据了头条新闻,但多层感知器(MLP)在特定的结构化用例中往往表现优于它们。简单并不意味着过时——它意味着适合目的。以下是 MLP 足够的场景。

-

表格数据:MLP 在结构化、列式数据方面仍然表现最佳,比如数据库和电子表格。这些数据集在金融、医疗保健、制造业和零售业等行业很常见,每个特征都代表一个独特的、定义明确的变量。这些行业通常没有大量数据来训练有效的 Transformer 模型,特别是在医疗保健领域,外部数据通常受到保护。

-

当特征独立或缺乏位置上下文时,依赖于学习标记之间关系的 Transformer 提供的优势有限。

-

研究和 Kaggle 竞赛经常表明,MLP(有时与 XGBoost 等基于树的模型配对)在这些任务中表现优于更复杂的神经架构。

-

中小型数据集:当对数百万或数十亿个数据点进行训练时,Transformer 通常会大放异彩。相比之下,由于参数较少和过拟合风险较小,MLP 在较小的数据集上更有效地泛化。

-

在标记数据稀缺或生成成本高昂的情况下,MLP 可以在没有深度预训练开销的情况下提供有竞争力的结果。

-

它们的简单性也使超参数调优更加简单。

-

实时和低延迟推理:当将模型部署到生产系统时,特别是在边缘设备或延迟敏感环境中,MLP 由于其最低的计算要求而非常理想。

-

MLP 加载速度快,内存轻量级,并在毫秒内产生预测。

-

它们适用于嵌入式系统、实时决策和功率和资源有限的移动应用。

-

可解释性和可调试性:与可能不透明和复杂的深层 Transformer 架构相比,MLP 更容易解释、监控和调试。

-

在医疗保健或金融等受监管行业,解释模型行为的能力至关重要。

-

MLP 使理解单个功能的影响变得更加容易,这对合规性、审计和信任至关重要。

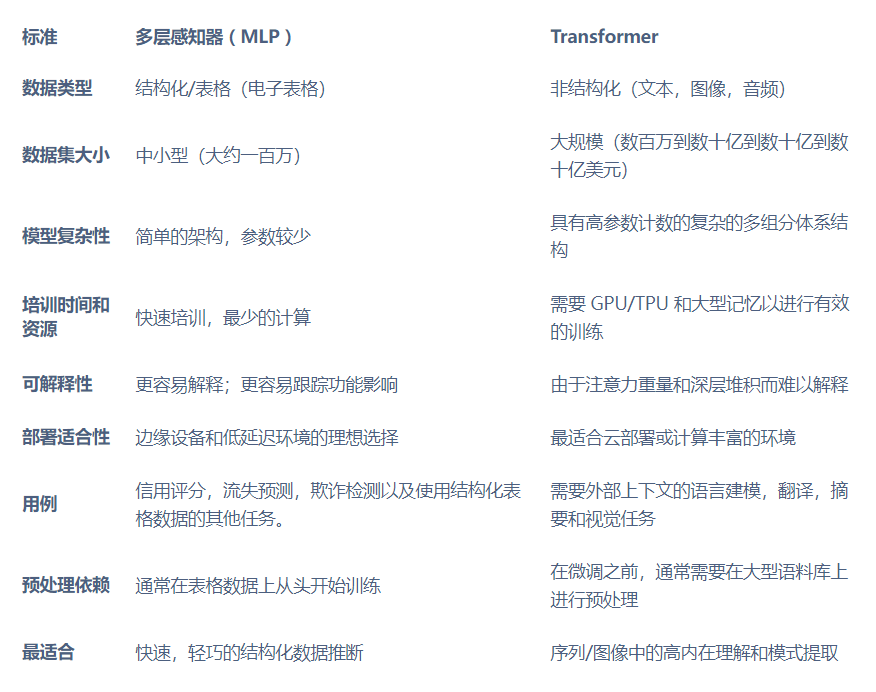

在当前的人工智能环境中,很容易默认使用最新、最复杂的模型,但架构的复杂性并不总是等同于实际优势。多层感知器(MLP)和 Transformers 具有不同的用途,了解何时使用每种感知器是构建高效、有效解决方案的关键。

MLP 擅长:

-

结构化/表格数据环境

-

中小型数据集

-

实时或资源受限的应用程序

-

要求可解释性和快速原型制作的场景

Transformer 最适合:

-

非结构化或高维数据,如文本、图像和音频

-

受益于基于注意力的学习的大规模数据集

-

需要深入理解上下文或长期依赖关系的任务

在实际的机器学习中,特别是在处理结构化数据、受限资源或实时系统时,多层感知器(MLP)仍然有效。它们为广泛的应用程序提供了更快的培训、更容易的部署和足够的性能,从财务评分系统到为 YouTube 等推荐引擎的某些方面提供动力。

最终,在 MLP 和 Transformer 之间进行选择取决于数据的性质、应用程序的约束和模型的目标。在许多情况下,像 MLP 这样的更简单的架构不仅足够了,而且比更大的架构表现更好,这提醒我们,在机器学习中,“更好”总是依赖于上下文的。

通过代理方法,生成式人工智能可以使用合适的人工智能模型,如 MLP,来解决特定的表格数据问题。这将是一种有趣的混合方法的实现,其中代理 LLM 可以将专门的任务传递给专门的 ML 模型。

如果您的企业或研究机构正在考虑扩展您的计算基础设施,联泰集群有各种可定制的平台来支持您的需求。请立即联系我们,获取免费报价和专家的配置建议。

相关贴子

-

人工智能与大模型

人工智能与大模型NVIDIA DGX Spark —— 随身而行的人工智能超级计算机

2026.01.09 18分钟阅读 -

人工智能与大模型

人工智能与大模型最大化人工智能效率:并行化和分布式训练

2025.01.27 23分钟阅读 -

人工智能与大模型

人工智能与大模型DeepSeek 算力平台推荐方案

2025.02.14 116分钟阅读