博客

数据中心中的 InfiniBand 与以太网

高速网络在高性能计算(HPC)和人工智能(AI)工作负载中起着至关重要的作用。这些应用需要快速的数据传输和低延迟,以最大限度地提高处理能力。以太网和 InfiniBand 是该领域的两种主要互联技术。本博客旨在帮助您评估哪种技术最适合您的计算基础设施。

以太网是一种广泛使用的网络协议,用于连接局域网(LANs)和数据中心中的设备,提供可扩展的带宽和广泛的兼容性。以太网最初是为办公局域网开发的,现已发展成为企业和云环境的标准互联。其广泛采用推动了快速创新,现代实施支持 100GbE、200GbE 甚至 400GbE 的速度。以太网端口有各种类型,如 RJ45、SFP、SFP+、QSFP+ 和 QSFP28,每种端口都针对特定的网络架构和数据传输需求而设计。RJ45 是最常见的,而 SFP 主要用于数据中心。

以太网的灵活性使其非常适合各种工作负载,包括虚拟化、云计算和大规模存储网络。高级功能,如融合以太网远程直接内存访问(RoCE)和与 NVIDIA BlueField 等数据处理单元(DPU)的集成,进一步扩展了其高性能应用的能力。

以太网是优先考虑成本效益的通用工作负载的可靠选择。由于其广泛采用以及与现有硬件和软件架构的兼容性,它提供了无缝的数据中心互操作性。云原生应用程序也可以从以太网中受益,特别是在与 NVIDIA BlueField DPU(数据处理单元)配对时,这些 DPU 将网络、存储和安全任务卸载到专用硬件上。

在以下情况下使用以太网:

-

部署虚拟化工作负载、微服务或容器化应用程序

-

用于控制计算基础架构中的其他节点

监控硬件资源

作业调度

-

在许多机架和/或位置上优先考虑成本和可扩展性

-

当部署使用标准 TCP/IP 协议并且不需要超低延迟时

-

您需要与云和混合环境兼容

InfiniBand 是一种高速、低延迟的互联技术,专为高性能计算(HPC)和人工智能工作负载而设计。它为远程直接内存访问(RDMA)提供了本机支持,使跨节点的内存之间能够直接通信,而 CPU 的参与程度最低。这种设计显著提高了数据吞吐量,并在要求苛刻的计算环境中减少了延迟。

InfiniBand 在几代产品中提供了卓越的带宽,包括 FDR(每条通道 14.0625 GB/s)、EDR(25 GB/s)、HDR(50 GB/s)和 NDR(100 GB/s)。它是人工智能模型训练、科学模拟和大规模集群的首选。其软件生态系统以 OpenMPI、Slurm 和 GPUDirect RDMA 等工具为特色,进一步优化了紧密耦合工作负载的性能。

InfiniBand 在需要超低延迟、高带宽和最小 CPU 消耗的环境中表现出色。它专为 HPC 工作负载、AI/ML 训练集群和大规模模拟而构建,特别是在工作负载需要或受益于节点间通信时。InfiniBand 包括本机 RDMA、高级拥塞控制以及与以太网相比在多节点部署中具有更好的可扩展性。

在以下情况下使用 InfiniBand:

-

跨多个计算节点运行工作负载

训练大规模 AI/ML 模型

运行 CFD、天气建模或分子动力学等科学模拟

-

低延迟是紧密耦合 HPC 工作负载的优先事项****

-

工作负载要求在持续负载下具有高吞吐量和可预测的网络性能

-

使用基于 MPI 的并行计算框架(可在 CFD、分子动力学等中找到)

-

您集群中的计算硬件包括使用 NVIDIA NVLink 的系统。

NVIDIA H 系列 NVL、NVIDIA HGX H 系列、NVIDIA HGX-B 系列和其他产品已经利用了低延迟 GPU 到 GPU,当与整个计算基础设施的低延迟网络配对时,可以最大限度地提高 GPU 到 GPU 的延迟

以太网和 InfiniBand 肯定共存于同一个数据中心架构中,而且它们经常在许多高性能环境中共存。这些混合结构架构允许组织根据其优势将每个网络结构分配给特定角色,从而平衡成本、性能和兼容性。

混合部署策略

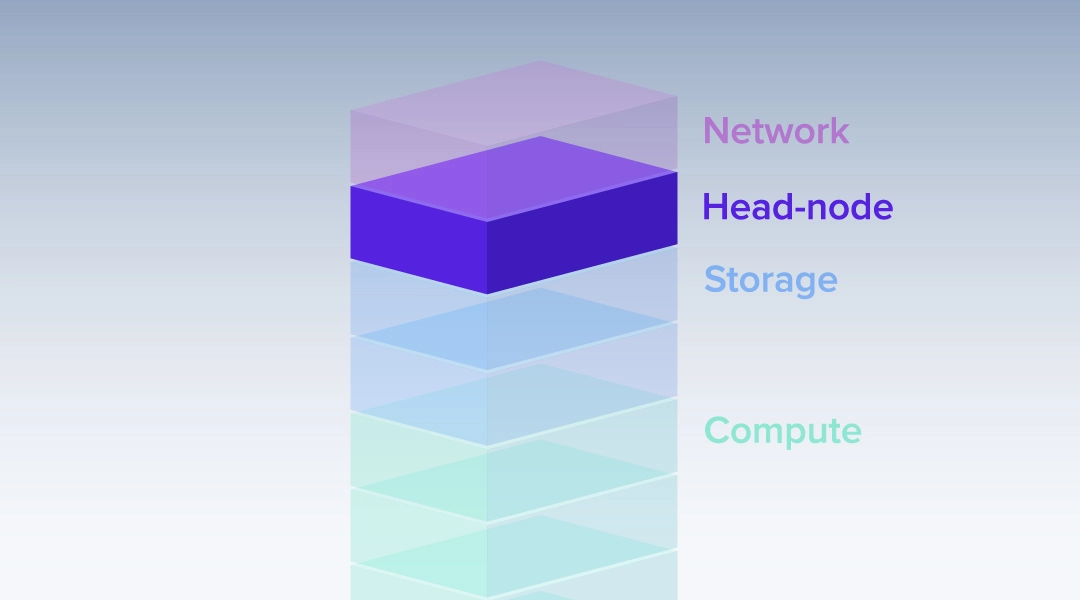

一种常见的方法是在控制和计算流量之间划分责任。大多数服务器已经内置了网络,可以从额外的 Infiniband NIC 中受益。

-

以太网处理控制平面或头节点,用于系统监控、作业调度、数据 I/O 和管理流量。它与标准工具的广泛兼容性使其成为通用基础设施功能的理想选择。

-

InfiniBand 将通过超低延迟、高带宽的链路连接计算节点,非常适合紧密耦合的并行处理。更高的性能加快了数据密集型工作负载的实现时间。

双网卡服务器设计

有时,部署需要服务器配备两个网络接口卡(NICs):一个用于以太网,一个用于 InfiniBand。InfiniBand NIC 处理 HPC 作业的 RDMA、MPI 流量和节点间数据移动。以太网 NIC 连接到存储、编排服务、云网关或管理接口,这些接口需要额外的速度,只有专用 NIC 才能提供。此设置在以下情况下特别有用:

-

使用 InfiniBand 上的 GPUDirect RDMA 和以太网上的 NFS 或 S3 的 AI 训练集群

-

通过以太网处理大量数据传输流量和通过 InfiniBand 处理 MPI 应用程序流量的 HPC 集群

-

混合云环境,以太网支持外部访问,InfiniBand 处理本地计算任务

以太网和 InfiniBand 具有明显的优缺点。以太网提供了成本效益和广泛的兼容性,而 InfiniBand 为要求苛刻的工作负载提供了无与伦比的性能。选择正确的网络结构取决于您的特定工作负载要求、规模和预算。

混合结构提供了灵活性,但引入了网络路由、监控和调优的复杂性。适当的规划是获得最大价值的必要条件。

联泰集群可以为您的特定用例提供网络设计或优化方面的帮助。我们能够根据您的工作负载构建的单节点和多节点集群与专业网络映射进行完全机架集成。如果有任何问题都可以联系我们联泰集群的工程师!

相关贴子

-

HPC

HPC集群拓扑结构:什么是头节点?

2024.01.12 42分钟阅读 -

HPC

HPC让 AI 训练不再「排队」!集群扩容,70 个科研任务并行无忧

2025.03.21 35分钟阅读 -

HPC

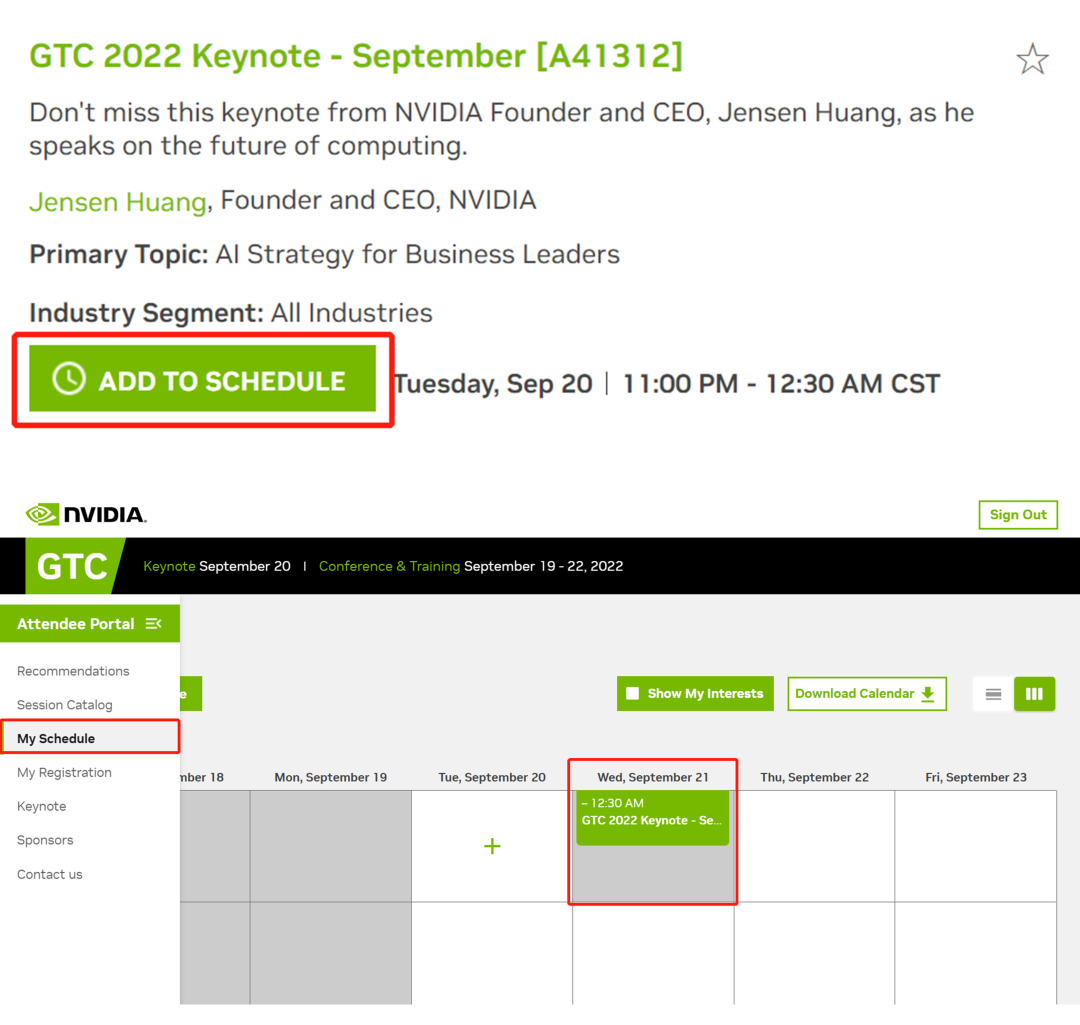

HPCGTC22 | 探索承载现代工作负载的加速网络!

2022.07.14 0分钟阅读