博客

技术分享

多站点分布式 GPU 架构:探索本地分布式 GPU 资源

2025.12.12

49分钟阅读

什么是多站点分布式 GPU 架构?

-

云 GPU 成本居高不下且难以预测,促使企业充分利用自有硬件资源; -

闲置 GPU 意味着资本浪费 —— 未使用的本地资源直接导致运营效率低下; -

数据主权与本地存储相关法规日趋严格,要求敏感工作负载必须在特定区域或设施内运行。

多站点分布式 GPU 架构的工作原理

1. 统一协同调度层

-

全局作业调度 -

多集群工作负载均衡 -

自动化算力共享 -

实时资源可视化

2. 策略驱动的工作负载部署

3. 默认数据本地执行

为何 2025 年需要多站点分布式 GPU 架构?

|

影响因素 |

说明 |

分布式 GPU 架构的作用 |

|

云 GPU 成本 |

高端加速器价格高昂且常处于缺货状态,导致长期云工作负载成本过高 |

将稳定工作负载转移到自有硬件,锁定可预测成本,规避云价格波动风险 |

|

出口费用 |

从云存储中迁移大型 AI 数据集会产生高额传输费用 |

支持在数据附近进行计算,避免重复传输,降低出口成本 |

|

本地闲置算力 |

为特定项目采购的 GPU 在非高峰时段常处于闲置状态,导致投资回报率(ROI)降低 |

整合多站点资源,动态重新分配闲置 GPU,最大化资源利用率 |

|

数据本地存储法规 |

《通用数据保护条例》(GDPR)、《健康保险流通与责任法案》(HIPAA)及 AI 相关法律要求敏感数据必须留在特定司法管辖区 |

在满足数据区域限制的同时,利用全局 GPU 资源池提升灵活性 |

-

提升利用率:实验室、办公室或灾难恢复(DR)站点的闲置 GPU 可转化为有效计算节点,避免资本沉淀; -

本地总拥有成本(TCO)优势:对于可预测的长期运行工作负载,使用自有 GPU 的 TCO 通常低于云租赁; -

混合灵活性:云 GPU 可用于突发负载、快速原型开发和临时项目,而核心工作负载留在本地,兼顾成本可控性与合规性; -

降低出口成本:在本地处理数据后再共享结果,减少高额跨区域传输费用。

多站点分布式 GPU 架构的核心价值应用场景

1. 数据附近的推理计算

-

超低延迟:最小化实时推理的往返时间; -

数据合规:确保计算符合数据驻留与主权要求; -

减轻网络压力:减少跨站点数据传输。

2. 非高峰时段的数据密集型处理

-

最大化利用率:确保 GPU 全天候高效运行; -

成本效益:将非紧急作业分配到资源最充足或成本最低的站点; -

性能可预测性:避免非高峰时段作业影响工作日的实时生产作业。

3. 跨地域联邦学习

-

数据隐私:敏感数据集始终留在所属区域; -

降低带宽需求:仅传输梯度 / 权重数据; -

更快收敛:多样化数据集在不重复的前提下提升模型质量。

4. 应对突发计算峰值

-

弹性横向扩展:利用其他区域未充分利用的 GPU 应对突发负载; -

成本控制:减少对高价按需云 GPU 的依赖; -

数据本地化:在扩展算力的同时,确保敏感工作负载留在本地。

多站点分布式 GPU 架构的局限性

-

跨站点紧耦合训练:大规模分布式深度学习(尤其是 Transformer 模型和扩散模型)需要频繁同步,高延迟、长距离链路会导致效率大幅下降; -

跨站点 GPU 质量不均:部分站点可能使用消费级 GPU,这类 GPU 缺乏企业级散热与耐用性、数据中心级监控功能,且驱动程序 / 固件更新不一致,易导致性能波动或可靠性问题; -

跨区域网络不稳定:即使是光纤连接的站点,也可能面临数据包丢失、网络拥堵和区域中断风险,进而延迟数据集传输、减慢检查点存储速度,并影响服务级别协议(SLA)的达成。

分布式 GPU 架构中的安全与治理

-

本地优先执行:敏感数据集留在所属司法管辖区,满足 GDPR、HIPAA 及新兴 AI 专项法规要求; -

跨站点流量加密:所有跨站点作业协同与模型更新需采用 TLS 1.3 或 mTLS 等协议加密; -

GPU 隔离:通过时间分片、GPU 分区或 NVIDIA MIG(多实例 GPU)等技术,确保不同团队的工作负载互不干扰,无法访问彼此的计算边界; -

集中式日志与审计:统一审计平台需捕获以下信息: -

用户身份

-

作业元数据

-

数据集访问

-

执行位置

构建本地分布式 GPU 架构的实用路径

-

从两个站点起步:验证基础联邦功能与工作负载分配能力; -

标准化工具链:统一容器镜像、驱动程序、协同调度工具与安全配置; -

运行混合工作负载:涵盖推理、批量作业与联邦学习场景; -

全面量化评估:监测资源利用率、作业耗时、成本节约量与带宽使用情况; -

逐步扩展:在验证可靠性与投资回报率(ROI)后,再增加更多站点。

核心要点

-

硬件 ROI 提升 —— 利用多站点闲置 GPU,避免资源浪费; -

云成本降低 —— 规避不可预测的 GPU 定价、出口费用与不必要的数据传输成本; -

治理与合规强化 —— 通过本地优先执行、跨站点加密通信与可审计的工作负载跟踪,满足合规要求; -

安全渐进扩展 —— 通过双站点试点,在 90 天内实现可量化成果,再逐步扩大规模。

相关贴子

-

技术分享

技术分享选 CPU 看核心数量还是时钟速度?

2024.10.11 27分钟阅读 -

技术分享

技术分享Ansys HPC Pack——解读 CPU 和 GPU 的 Ansys 许可

2024.08.02 83分钟阅读 -

技术分享

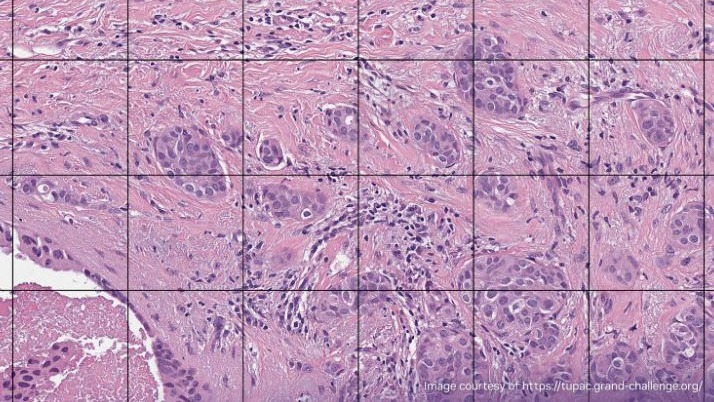

技术分享使用 cuCIM 和 NVIDIA GPU DIRECT STORAGE加速数字病理学工作流程

2023.01.12 86分钟阅读