博客

技术分享

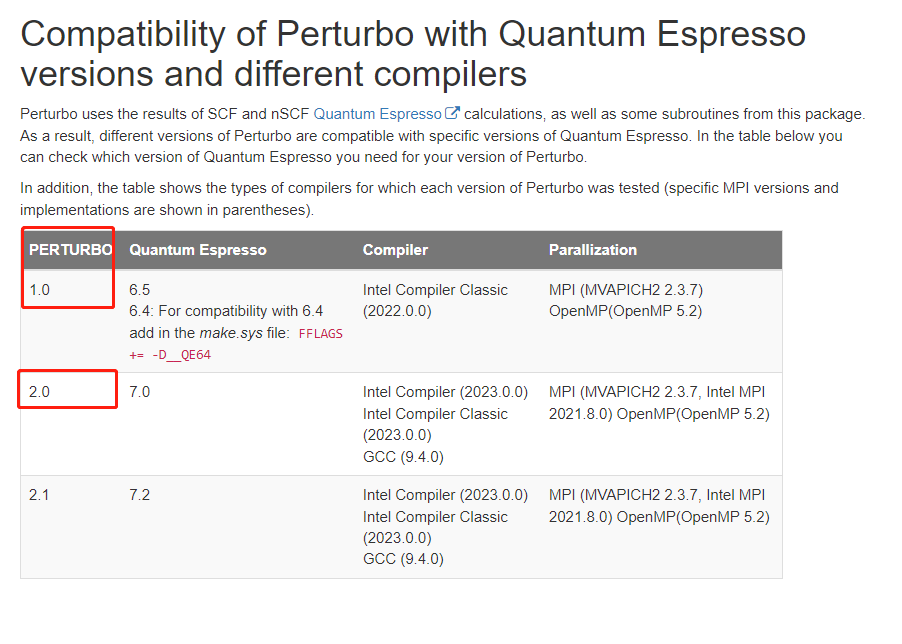

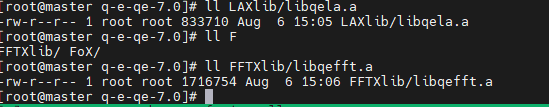

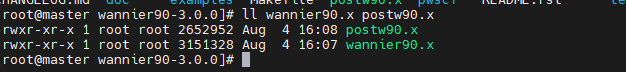

【技术大讲堂】Perturbo-2.0 的安装

2024.09.13

29分钟阅读

相关贴子

-

技术分享

技术分享基于 LoRA 技术的人工智能模型微调

2025.12.05 48分钟阅读 -

技术分享

技术分享这台服务器正在悄悄改变中国 AI 产业格局!

2025.07.04 33分钟阅读 -

技术分享

技术分享如何在非传统数据中心部署 GPU 服务器

2025.07.18 65分钟阅读